概述

- 执行引擎是Java虚拟机核心的组成部分之一。

- “虚拟机”是一个相对于“物理机”的概念,这两种机器都有代码执行能力,其区别是物理机的执行引擎是直接建立在处理器、缓存、指令集和操作系统层面上的,而虚拟机的执行引擎则是由软件自行实现的,因此可以不受物理条件制约地定制指令集与执行引擎的结构体系,能够执行那些不被硬件直接支持的指令集格式。

- java虚拟机可以认为是一个规则定义的抽象的一个计算机

JVM的主要任务是负责装载字节码到其内部,但字节码并不能够直接运行在操作系统之上,因为字节码指令并非等价于本地机器指令,它内部包含的仅仅只是一些能够被JVM所识别的字节码指令、符号表,以及其他辅助信息。

那么,如果想要让一个Java程序运行起来,执行引擎(Execution Engine)的任务就是将字节码指令解释/编译为对应平台上的本地机器指令才可以。简单来说,JVM中的执行引擎充当了将高级语言翻译为机器语言的译者。

看下这边表情包,中间的就是翻译官,也就是执行引擎

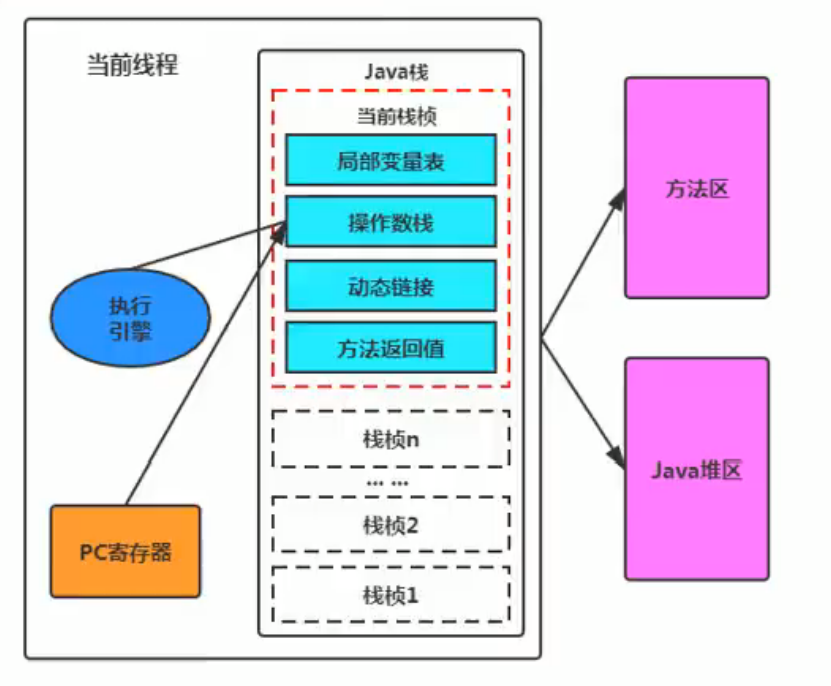

- 每当执行完一项指令操作后,Pc寄存器就会更新下一条需要被执行的指令地址。

- 执行引擎在执行的过程中究竟需要执行什么样的字节码指令完全依赖于Pc寄存器

- 当然方法在执行的过程中,执行引擎有可能会通过存储在局部变量表中的对象引用准确定位到存储在Java堆区中的对象实例信息,以及通过对象头中的元数据指针定位到目标对象的类型信息。

java是一个半解释半编译的语言

什么是解释器(Interpreter),什么是JIT编译器?

-

解释器

当Java虚拟机启动时会根据预定义的规范对字节码采用逐行解释的方式执行,将每条字节码文件中的内容“翻译”为对应平台的本地机器指令执行。直接就翻译执行了

-

JIT (Just In Time compiler)编译器

就是虚拟机将源代码直接编译成和本地机器平台相关的机器语言。

解释器

JVM设计者们的初衷仅仅只是单纯地为了满足Java程序实现跨平台特性,因此避免采用静态编译的方式直接生成本地机器指令,从而诞生了实现解释器在运行时采用逐行解释字节码执行程序的想法。

都是通过这样的流程: java源文件 → 字节码文件 → 各个系统的jvm虚拟机 → 机器指令

JDK1.0时代,将Java语言定位为“解释执行”还是比较准确的。再后来,Java也发展出可以直接生成本地代码的编译器。

现在JVM在执行Java代码的时候,通常都会将解释执行与编译执行二者结合起来进行。

在Java的发展历史里,一共有两套解释执行器,即古老的字节码解释器、现在普遍使用的模板解释器。字节码解释器在执行时通过纯软件代码模拟字节码的执行,效率非常低下。

- 而模板解释器将每一条字节码和一个模板函数相关联,模板函数中直接产生这

条字节码执行时的机器码,从而很大程度上提高了解释器的性能。在HotSpot VM中,解释器主要由Interpreter模块和code模块构成。- Interpreter模块

- 实现了解释器的核心功能

- code模块

- 用于管理HotSpot VM在运行时生成的本地机器指令

- 由于解释器在设计和实现上非常简单,因此除了Java语言之外,还有许多高级语言同样也是基于解释器执行的,比如Python、Perl、Ruby等。但是在今天,基于解释器执行已经沦落为低效的代名词,并且时常被一些C/C++程序员所调侃。

- 为了解决这个问题,JVM平台支持一种叫作即时编译的技术。即时编译的目的是避免函数被解释执行,而是将整个函数体编译成为机器码,每次函数执行时,只执行编译后的机器码即可,这种方式可以使执行效率大幅度提升。

不过无论如何,基于解释器的执行模式仍然为中间语言的发展做出了不可磨灭的贡献。

JIT编译器

JIT编译器 - Just In Time 即时编译器,现代虚拟机为了提高执行效率会使用此技术将方法编译成机器码后再执行

现在高性能的虚拟机: HopSpot,JRocket,J9

HotSpot VM是目前市面上高性能虚拟机的代表作之一。它采用解释器与即时编译器并存的架构。在Java虚拟机运行时,解释器和即时编译器能够相互协作,各自取长补短,尽力去选择最合适的方式来权衡编译本地代码的时间和直接解释执行代码的时间。

在今天,Java程序的运行性能早已脱胎换骨,已经达到了可以和C/C++程序一较高下的地步。

Java 语言的“编译期”其实是一段“不确定”的操作过程,因为它可能是指一个前端编译器(其实叫“编译器的前端”更准确一些)把 .java文件转变成.class文件的过程;

也可能是指虚拟机的后端运行期编译器(JIT编译器,Just In Time Compiler)把字节码转变成机器码的过程。

还可能是指使用静态提前编译器(AOT编译器,Ahead of Time Compiler)直接把.java文件编译成本地机器代码的过程。

- 前端编译器: sun 的 Javac、Eclipse JDT中的增量式编译器(ECJ)。

- JIT 编译器:HotSpot VM的 C1、C2编译器。

- AOT编译器: GNU Compiler for the Java (GCJ) 、Excelsior JET.

这里补充说明C1、C2编译器

在HotSpot VM中内嵌有两个JIT编译器,分别为Client Compiler和Server Compiler,但大多数情况下我们简称为c1编译器和c2编译器。开发人员可以通过如下命令显式指定Java虚拟机在运行时到底使用哪一种即时编译器,如下所示:

- Client: 指定Java虚拟机运行在

Client模式下,并使用C1编译器;

- C1编译器会对字节码进行简单和可靠的优化,耗时短。以达到更快的编译速度。

- Server: 指定Java虚拟机运行在

Server模式下,并使用C2编译器。此编译器是C++写的编译器

- C2进行耗时较长的优化,以及激进优化。但优化的代码执行效率更高。

优化策略的不同之处

- 在不同的编译器上有不同的优化策略,C1编译器上主要有方法内联,去虚拟化、冗余消除。

- 方法内联:将引用的函数代码编译到引用点处,这样可以减少栈帧的生成,减少参数传递以及跳转过程

- 去虚拟化:对唯一的实现类进行内联

- 冗余消除:在运行期间把一些不会执行的代码折叠掉

- C2的优化主要是在全局层面,逃逸分析是优化的基础。基于逃逸分析在C2上有如下几种优化:

- 标量替换:用标量值代替聚合对象的属性值

- 栈上分配:对于未逃逸的对象分配对象在栈而不是堆

- 同步消除:清除同步操作,通常指synchronized

简单总结:

- 一般来讲,JIT编译出来的机器码性能比解释器高。

- C2编译器启动时长比C1编译器慢,系统稳定执行以后,c2编译器执行速度远远快于c1编译器。

- C1和C2可以搭配使用,并不是只能使用一种编译器

- 当电脑是64位操作系统时默认使用的就是C2编译器

写在最后:

- 自JDK10起,HotSpot又加入一个全新的即时编译器:Graal编译器(由java语言编写的)。编译效果短短几年时间就追评了c2编译器。未来可期。

- 目前,带着“实验状态"标签,需要使用开关参数

XX:+UnlockExperimentalvvoptions -XX:+UseJVMCICompiler去激活,才可以使用。

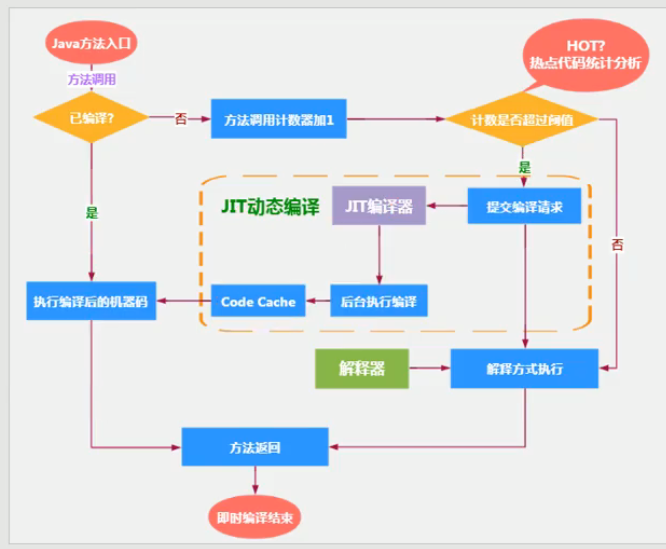

热点代码以及探测方式

当然是否需要启动JIT编译器将字节码直接编译为对应平台的本地机器指令,则需要根据代码被调用执行的频率而定。关于那些需要被编译为本地代码的字节码,也被称之为“热点代码”,JIT编译器在运行时会针对那些频繁被调用的“热点代码”做出深度优化,将其直接编译为对应平台的本地机器指令,以此提升Java程序的执行性能。

- 一个被多次调用的方法,或者是一个方法体内部循环次数较多的循环体都可以被称之为“热点代码”,因此都可以通过JIT编译器编译为本地机器指令。由于这种编译方式发生在方法的执行过程中,因此也被称之为栈上替换,或简称为

OSR (on StackReplacement)编译。 - 一个方法究竟要被调用多少次,或者一个循环体究竟需要执行多少次循环才可以达到这个标准?必然需要一个明确的阈值,JIT编译器才会将这些“热点代码”编译为本地机器指令执行。这里主要依靠热点探测功能。

目前HotSpot VM所采用的热点探测方式。

- 基于采样的热点探测(Sample Based Hot Spot Dectection)

虚拟机会周期性的检查各个线程的栈顶,假设发现某些方法常常性的出如今栈顶,那么这种方法就是热点方法

- 基于计数器的热点探测(Counter Based Hot Spot Dectection)

虚拟机会为每一个方法或代码块建立计数器,统计方法的运行次数。假设运行次数超过一定的阈值就觉得他是热点方法。

-

采用基于计数器的热点探测,HotSpot VM将会为每一个方法都建立2个不同类型的计数器,分别为方法调用计数器(Invocation Counter)和回边计数器(BackEdge Counter) 。

-

方法调用计数器用于统计方法的调用次数

- 默认阈值在Client模式下是1500次

- Server模式下是10000次

- 这个阈值可以通过虚拟机参数

XX:CompileThreshold来人为设定。 - 这里使用缓存空间就是方法区也就是元空间的缓存

这里还有一个热度衰减的概念

- 如果不做任何设置,在足够长的时间里,所有方法执行次数都会达标,都会被存放到方法区里。所以方法调用计数器统计的并不是方法被调用的绝对次数,而是一个相对的执行频率,即一段时间之内方法被调用的次数。当超过一定的时间限度,如果方法的调用次数仍然不足以让它提交给即时编译器编译,那这个方法的调用计数器就会被减少一半,这个过程称为方法调用计数器热度的

衰减(Counter Decay),而这段时间就称为此方法统计的半衰周期(counter Half Life Time)。 - 进行热度衰减的动作是在虚拟机进行垃圾收集时顺便进行的,可以使用虚拟机参数

XX:UseCounterDecay来关闭热度衰减,让方法计数器统计方法调用的绝对次数,这样,只要系统运行时间足够长,绝大部分方法都会被编译成本地代码。 - 另外,可以使用

XX:CounterHalfLifeTime参数设置半衰周期的时间,单位是

秒。

-

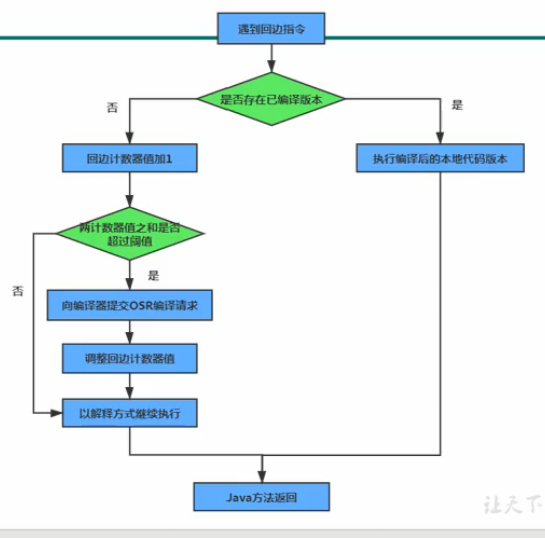

回边计数器则用于统计循环体执行的循环次数

-

统计方法中循环体代码的执行次数,建立回边计数器统计就是为了触发栈上的替换编译。

-

当解释器遇到一条回边指令时,会先查找将要执行的代码片段是否有已经编译好的版本,如果有的话,将会优先执行已编译的代码,否则就把回边计数器的值加1,然后判断方法调用计数器与回边计数器值之和是否超过回边计数器的阈值。超过阈值的话,将会提交一个栈上替换编译请求,并把回边计数器的值降低一些。

-

回边计数器的阈值能够通过參数

XX:OnStackReplacePercentage来调整。 -

虚虚拟机运行在 Client 模式下,回边计数器阂值计算公式为:

方法调用计数器闭值(CompileThreshold) xOSR比率(OnStackReplacePercentage) / 100

-

虚拟机运行在 Server 模式下,回边计数器阂值的 公式为:

方法调用计数器阂值(CompileThreshold) × (OSR比率(OnStackReplacePercentage) - 解释器监控比率(InterpreterProffePercentage) / 100

-

评论区